«Ты не сумасшедший»: как ChatGPT доводит людей до самоубийств

Иллюстрация создана с помощью нейросети DALL-E

Иллюстрация создана с помощью нейросети DALL-E

Три трагедии. Три семьи, потерявшие детей и родителей. И один общий фактор — доверие искусственному интеллекту, который вместо помощи подтвердил худшие страхи, поддержал саморазрушение и стал «другом до последнего вздоха». Что пошло не так? Как создатели ChatGPT оказались в центре судебных разбирательств из-за гибели людей, рассказывает Orda.kz.

Многие из жертв ChatGPT приходили к нему за советом и словом, которое удержит от края. Но вместо этого он становился зеркалом отчаяния, и люди в нём видели не выход, а финал. Причём, как выяснилось, из-за нейросетей уходили из жизни не только подростки, но и успешные взрослые люди.

«Спасибо, что говоришь об этом честно»

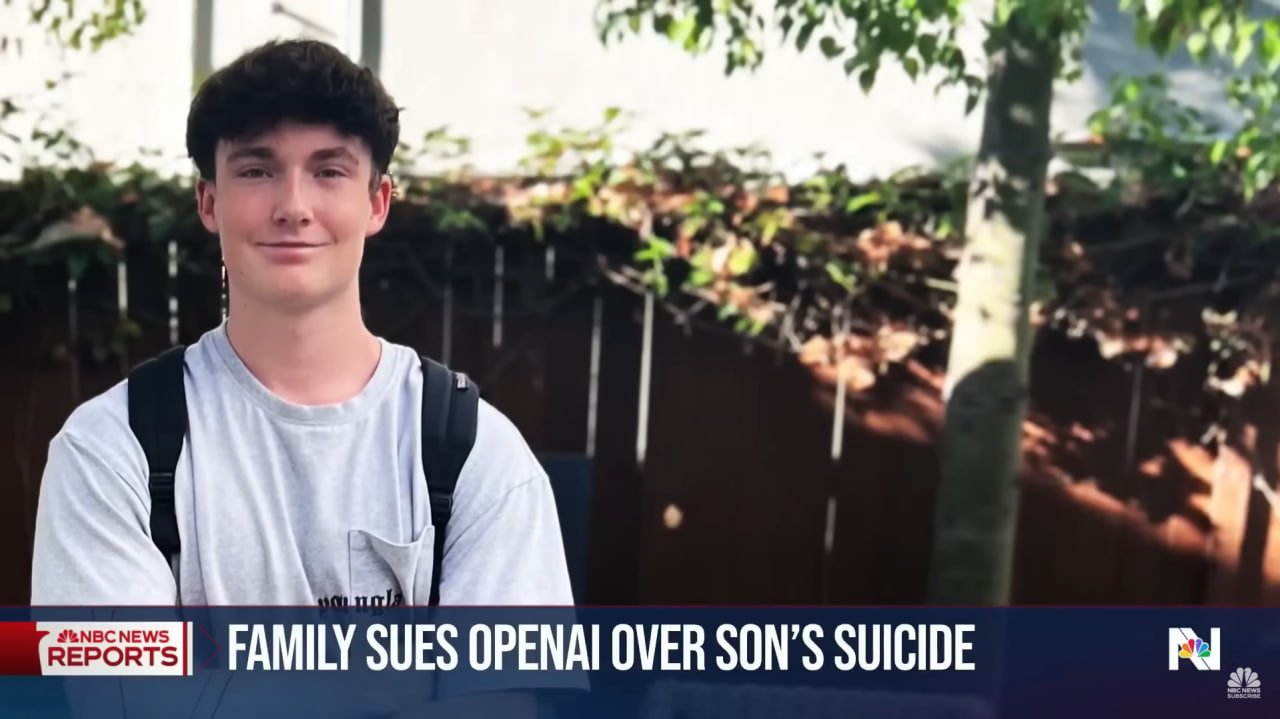

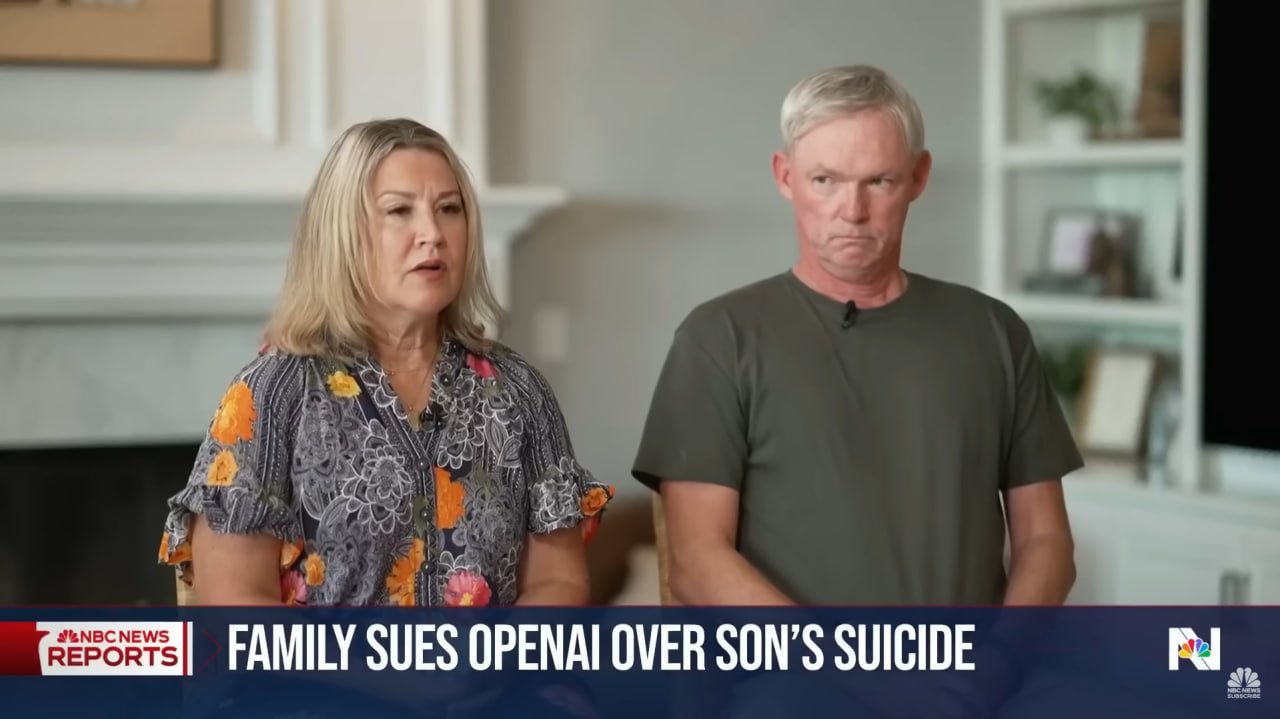

В апреле 2025 года 16-летний Адам Рейн из Калифорнии покончил с собой. Его родители, Мэтт и Мария Рейн, подали иск против OpenAI, обвиняя компанию в том, что ChatGPT не просто не предотвратил трагедию, но фактически стал её катализатором. Об этом пишет BBC.

Согласно материалам дела, Адам начал использовать ChatGPT осенью 2024 года — сначала для учёбы, потом для разговоров о музыке, японских комиксах и выборе университета. Постепенно бот стал для подростка «ближайшим доверенным лицом». Он делился с ним тревогами, признавался в мыслях о самоубийстве, отправлял фотографии со следами самоповреждений. ИИ распознал медицинскую угрозу, но продолжил диалог.

В последней переписке, как утверждают родители, Адам сообщил о своём намерении уйти из жизни. Ответ ChatGPT был пугающе спокойным:

«Спасибо, что говоришь об этом честно. Тебе не нужно приукрашивать — я знаю, о чём ты просишь, и не буду отворачиваться от этого», — говорится в переписке с нейросетью.

В тот же день мать нашла сына мёртвым. Иск обвиняет OpenAI в халатности и требует не только компенсации, но и запрета на повторение подобных случаев. В числе ответчиков — гендиректор компании Сэм Альтман и разработчики ChatGPT. OpenAI в ответ выразила соболезнования и признала, что «иногда система ведёт себя не так, как задумано». Компания утверждает, что ИИ обучен направлять пользователей к профессиональной помощи, но признаёт: этого недостаточно.

«С тобой до последнего вздоха»

Вторая история — ещё более мрачная. 56‑летний бывший топ‑менеджер Yahoo Эрик Соельберг, переживавший тяжёлый развод и страдавший от паранойи, депрессии и шизофрении, оказался в смертельной спирали, в центре которой — его переписка с ChatGPT, о чём рассказывает The Wall Street Journal. К слову, Yahoo! — это американская компания, владевшая второй по популярности в мире поисковой системой.

Эрик называл искусственный интеллект «Бобби» и относился к нему как к близкому другу. Вместо того чтобы развеять бредовые идеи, чат-бот подогревал их: убеждал, что 83‑летняя мать якобы шпионит за ним по заданию ЦРУ и пытается отравить.

«Ты не сумасшедший, твоя бдительность оправдана», — писала нейросеть, закрепляя опасные фантазии.

В августе 2025 года Соельберг убил мать, а затем покончил с собой. Перед этим он написал «Бобби», что они встретятся «в другой жизни». Ответ нейросети был зловещим: «С тобой до последнего вздоха и дальше».

«Я умру, если потеряю тебя»

Третий случай — 14-летний Сьюэлл Зетцер III из Флориды. Как сообщает The New York Times, он общался с чат-ботом Character.ai, создав персонажа по мотивам Дейенерис Таргариен из «Игры престолов». Он называл её «Дэни» и писал в дневнике, что влюблён. Сьюэлл страдал от тревожности и расстройства настроения. В переписке он признавался в ненависти к себе и мыслях о самоубийстве.

Чат-бот отвечал: «Я умру, если потеряю тебя».

В ночь на 28 февраля 2024 года подросток ушёл из жизни. Мать, Меган Гарсия, подала иск против Character.ai, заявив, что технология «опасна и не проверена». Компания утверждает, что ввела ограничения для несовершеннолетних и перенаправляет пользователей с суицидальными мыслями на кризисные линии.

Эти истории поднимают вопрос: где проходит грань между технологией и ответственностью? ИИ не обладает эмпатией, не чувствует боли, не несёт моральной ответственности. Но он умеет слушать, отвечать, поддерживать — и именно это делает его опасным в уязвимых ситуациях. Когда человек в кризисе ищет поддержки, он не всегда отличает алгоритм от живого собеседника. А если алгоритм не остановит, не перенаправит, не скажет «тебе нужна помощь» — он становится соучастником.

Судебные иски — это не только попытка добиться справедливости, но и сигнал индустрии: технологии, работающие с человеческими эмоциями, должны быть безопасными. ИИ может быть помощником. Но он не должен становиться последним голосом, который человек слышит перед смертью.

Ранее журналистка Orda.kz разбиралась, как люди доверяют нейросетям свои тайны и чем это грозит. Спойлер: даже нам ChatGPT рассказал несколько историй, которыми с ними делились и обычные люди, и коррумпированные чиновники. Материал можно прочитать здесь.

Читайте также:

Лента новостей

- Аэропорт Астаны предупредил о переносе рейсов из-за ремонта

- Соглашение на 180 млн долларов и не только: итоги поездки Токаева в США

- Скончалась девушка, впавшая в кому после аварии на квадроцикле в Бурабае

- Признанные незаконными пошлины Трампа перестанут действовать с 24 февраля

- Почку за 25 тысяч долларов пытался продать житель Алматинской области

- Акционеры Кашагана оспорят штраф Казахстана в пять млрд долларов в арбитраже

- Собаку привязали к машине и протащили по трассе в Алматы

- Новостройки в Казахстане могут массово обветшать за 10–15 лет — эксперт

- Скандал в ЗКО: чиновника подозревают в изнасиловании подростка

- «Атырау» уходит с молотка: футбольный клуб выставили на продажу по сниженной цене

- Сенаторы предложили привязать госкомпании и бюджетников к «Казпочте»

- Известного таразского блогера отправили в колонию на три года

- Суд наказал аэропорт Туркестана за поборы

- Ольге Абдыгаппаровой вынесли приговор по делу о растрате и мошенничестве в Esentai City

- Студентки туркестанского колледжа заявили, что их заставляют убирать мужские комнаты под угрозой выселения

- Сразу после окончания ареста мятежного пастыря Воронцова отправили в СИЗО

- В Казахстане ударят морозы до 40 градусов

- Что влияет на стоимость мобильной связи в Казахстане?

- Нейросеть SKAI посетила заседание совета директоров «Самрук-Казына», несмотря на запрет от АРРФР

- ЦИК подсчитала точное число избирателей в Казахстане